Парсеры для сбора данных

1

2

2

3

скачать программу. инструкция ,

3

4

Что такое парсинг и что о нём обязательно нужно знать маркетологу

Парсинг ускоряет работу в сотни раз. Рассказываем, какие данные можно собирать с помощью него и что об этом говорит закон.

Кадр: фильм «Тёмный рыцарь» / Universal Pictures

Собрать данные с 50 страниц сайта можно за пару часов. Но если этих страниц сотни и тысячи, работа займёт недели. Чтобы ускорить её, можно использовать парсинг.

В этом материале Skillbox Media разберёмся:

- что такое парсинг;

- что можно парсить и зачем это нужно;

- что о парсинге говорит закон;

- как можно парсить данные.

Что такое парсинг

Парсинг — автоматизированный сбор и систематизация информации из открытых источников с помощью скриптов. Другое название этого процесса — веб-скрейпинг.

Скрипты, которые собирают и систематизируют информацию, называются парсерами. Они работают так:

- ищут источники по заданным параметрам — например, парсеру можно дать список сайтов, а он найдёт на них страницы с ценами;

- извлекают из источников нужную информацию — несколько строк текста, ссылку или сумму;

- преобразуют информацию — например, парсер может взять фрагмент из HTML-документа и преобразовать его в текст без кода;

- сохраняют информацию в нужном формате — например, в виде списка или таблицы в Excel.

Парсеры работают на разных языках программирования — Python, JavaScript, PHP 5 и других. Подробнее о принципах работы парсера на JavaScript можно почитать здесь.

Смысл парсинга в том, чтобы ускорить рутинную работу. Чтобы собрать и сохранить в таблице список из тысячи статей на сайте, человек потратит часы. Парсер сделает эту работу за несколько минут. Парсер ускоряет работу в сотни раз и допускает меньше ошибок, чем человек.

Что можно парсить и зачем это нужно

Количество способов использования парсинга бесконечно. С помощью парсинга можно извлекать любую информацию из исходного кода страниц сайтов, из соцсетей, каталогов, файлов и документов.

Мы перечислим самые распространённые способы применения парсинга в маркетинге. Парсерами ищут:

- Цены на товары и услуги. Парсинг сайтов помогает быстро собрать информацию о ценах на продукты конкурентов. Если проводить его регулярно, можно всегда поддерживать конкурентную цену на продукт. Снижать её, когда конкуренты делают скидки, — и повышать, если их цены тоже растут.

- Поисковые фразы. Можно использовать парсинг выдачи «Яндекса», чтобы собрать все возможные ключевые слова. Парсер может сохранять фразы из поисковых подсказок и блока «Люди ищут» внизу.

- Целевую аудиторию в соцсетях. С помощью парсинга собирают людей по нужным критериям — например, тех, кто проявляет активность в сообществах конкурентов. Потом этим людям показывают рекламу. Сейчас очень популярен парсинг во «ВКонтакте», в других соцсетях его используют реже.

- Битые ссылки. Так называют ссылки, ведущие на несуществующую страницу. Парсер может быстро обойти весь сайт и сохранить в документе все битые ссылки — и страницы, на которых они расположены.

- Идеи для контента. Парсер может собрать в одном месте посты или статьи на выбранную тему. Это нужно, чтобы изучить сразу всех конкурентов и выпустить интересный контент. Некоторые парсят сайты, чтобы копировать контент, — например, добывают так описания для тысяч товаров в интернет-магазине.

- Отзывы. Если компания занимается SERM — управлением репутацией в поисковых системах, она может использовать парсеры, чтобы находить новые отзывы. Тогда программы каждый день будут собирать отзывы, появившиеся за последние сутки, а менеджеры быстро отреагируют на них.

Законно ли использовать парсинг

Да, потому что парсинг — просто автоматизация. Парсеры работают с данными, которые можно найти и вручную. А закон не запрещает использовать любые методы сбора общедоступных данных.

Но ограничения всё-таки есть. Парсинг нельзя использовать, чтобы нарушать закон:

- Нагружать парсером сервер сайта так, что он перестаёт работать. Это одна из разновидностей DDoS-атак. За неё могут наказать по статьям 272 или 273 УК РФ штрафом до 200–500 тысяч рублей и лишением свободы на срок до семи лет.

- Использовать полученные данные для спама. Штраф за спам по закону «О рекламе» достигает 500 тысяч рублей за одно сообщение.

- Использовать данные для плагиата. Нарушение авторских прав описано в статье 146 УК РФ. За него могут оштрафовать на сумму до 500 тысяч рублей.

- Распространять личные данные пользователей, полученные в ходе парсинга. Делать это запрещает поправка к закону о персональных данных. За нарушение этого закона предусмотрены штрафы до 18 миллионов рублей для юридических лиц.

Таких преступлений много, а найти виновного сложно. Поэтому наказывают за них редко.

Как можно парсить данные

Есть два способа парсить данные: создать парсер с нуля и использовать готовое решение.

Создание парсера с нуля обычно нужно, если готовые решения не подходят. Например, свои парсеры делают большие интернет-магазины с тысячами товаров, чтобы находить позиции без описания или без важных характеристик.

Поручить создание парсера можно разработчику. А можно сделать его самому, даже если вы не разбираетесь в программировании. В Skillbox проходит бесплатный интенсив, на котором вы сможете создать парсер сайтов на Python за три дня.

Готовые решения подходят, чтобы закрыть типовые задачи. Общедоступных парсеров много. Например:

- TargetHunter собирает целевую аудиторию во «ВКонтакте».

- uXprice мониторит цены конкурентов в интернет-магазинах и рекомендует оптимальные.

- A-Parser — это 90+ парсеров сайтов, поисковых систем и SEO-сервисов. Их можно использовать, чтобы спарсить поисковые фразы или адреса компаний из «Яндекс.Карт».

Главное — в четырёх пунктах

- Парсинг — автоматизированный сбор и систематизация данных. Его проводят с помощью программ, которые называются парсерами. Парсинг нужен, чтобы ускорить рутинную работу.

- Парсить можно что угодно — цены конкурентов, поисковые фразы, аккаунты в соцсетях, битые ссылки.

- Закон не запрещает парсинг. Но его нельзя использовать для преступлений: чтобы распространять личные данные людей, спамить, перегружать сервер сайта.

- Чтобы парсить данные, можно создать парсер с нуля или использовать готовые решения. Последних много — важно найти подходящее для ваших задач.

Материалы Skillbox Media о рекламе и продвижении сайтов

- Что такое уникальность текста, зачем её проверять и как она влияет на SEO

- Руководство по myTarget: как настроить эффективную рекламу во «ВКонтакте» и на других площадках

- Что такое УТП — и как создать сильное предложение, чтобы продавать больше

- Гайд по «Яндекс.Вордстату»: подбираем ключевые слова для SEO, контента и контекстной рекламы

- Как использовать линкбилдинг, чтобы получать хорошие ссылки и не подпасть под санкции

https://skillbox.ru/media/marketing/chto-takoe-parsing-i-chto-o-nyem-obyazatelno-nuzhno-znat-marketologu/

———————————————————————

30+ парсеров для сбора данных с любого сайта

Десктопные/облачные, платные/бесплатные, для SEO, для совместных покупок, для наполнения сайтов, для сбора цен… В обилии парсеров можно утонуть.

Мы разложили все по полочкам и собрали самые толковые инструменты парсинга — чтобы вы могли быстро и просто собрать открытую информацию с любого сайта.

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

- Цены. Актуальная задача для интернет-магазинов. Например, с помощью парсинга вы можете регулярно отслеживать цены конкурентов по тем товарам, которые продаются у вас. Или актуализировать цены на своем сайте в соответствии с ценами поставщика (если у него есть свой сайт).

- Товарные позиции: названия, артикулы, описания, характеристики и фото. Например, если у вашего поставщика есть сайт с каталогом, но нет выгрузки для вашего магазина, вы можете спарсить все нужные позиции, а не добавлять их вручную. Это экономит время.

- Метаданные: SEO-специалисты могут парсить содержимое тегов title, description и другие метаданные.

- Анализ сайта. Так можно быстро находить страницы с ошибкой 404, редиректы, неработающие ссылки и т. д.

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Но если вы хотите собрать персональные данные пользователей и использовать их для email-рассылок или таргетированной рекламы, это уже будет незаконно (эти данные защищены законом о персональных данных).

Десктопные и облачные парсеры

Облачные парсеры

Основное преимущество облачных парсеров — не нужно ничего скачивать и устанавливать на компьютер. Вся работа производится «в облаке», а вы только скачиваете результаты работы алгоритмов. У таких парсеров может быть веб-интерфейс и/или API (полезно, если вы хотите автоматизировать парсинг данных и делать его регулярно).

Например, вот англоязычные облачные парсеры:

Из русскоязычных облачных парсеров можно привести такие:

Любой из сервисов, приведенных выше, можно протестировать в бесплатной версии. Правда, этого достаточно только для того, чтобы оценить базовые возможности и познакомиться с функционалом. В бесплатной версии есть ограничения: либо по объему парсинга данных, либо по времени пользования сервисом.

Десктопные парсеры

Большинство десктопных парсеров разработаны под Windows — на macOS их необходимо запускать с виртуальных машин. Также некоторые парсеры имеют портативные версии — можно запускать с флешки или внешнего накопителя.

Популярные десктопные парсеры:

- ParserOK,

- Datacol,

- Screaming Frog, ComparseR, Netpeak Spider — об этих инструментах чуть позже поговорим подробнее.

Виды парсеров по технологии

Браузерные расширения

Для парсинга данных есть много браузерных расширений, которые собирают нужные данные из исходного кода страниц и позволяют сохранять в удобном формате (например, в XML или XLSX).

Парсеры-расширения — хороший вариант, если вам нужно собирать небольшие объемы данных (с одной или парочки страниц). Вот популярные парсеры для Google Chrome:

Надстройки для Excel

Программное обеспечение в виде надстройки для Microsoft Excel. Например, ParserOK. В подобных парсерах используются макросы — результаты парсинга сразу выгружаются в XLS или CSV.

Google Таблицы

С помощью двух несложных формул и Google Таблицы можно собирать любые данные с сайтов бесплатно.

Эти формулы: IMPORTXML и IMPORTHTML.

IMPORTXML

Функция использует язык запросов XPath и позволяет парсить данные с XML-фидов, HTML-страниц и других источников.

Вот так выглядит функция:

IMPORTXML("https://site.com/catalog"; "//a/@href")Функция принимает два значения:

- ссылку на страницу или фид, из которого нужно получить данные;

- второе значение — XPath-запрос (специальный запрос, который указывает, какой именно элемент с данными нужно спарсить).

Хорошая новость в том, что вам не обязательно изучать синтаксис XPath-запросов. Чтобы получить XPath-запрос для элемента с данными, нужно открыть инструменты разработчика в браузере, кликнуть правой кнопкой мыши по нужному элементу и выбрать: Копировать → Копировать XPath.

С помощью IMPORTXML можно собирать практически любые данные с html-страниц: заголовки, описания, мета-теги, цены и т.д.

IMPORTHTML

У этой функции меньше возможностей — с ее помощью можно собрать данные из таблиц или списков на странице. Вот пример функции IMPORTHTML:

IMPORTHTML("https://https://site.com/catalog/sweets"; "table"; 4)Она принимает три значения:

- Ссылку на страницу, с которой необходимо собрать данные.

- Параметр элемента, который содержит нужные данные. Если хотите собрать информацию из таблицы, укажите «table». Для парсинга списков — параметр «list».

- Число — порядковый номер элемента в коде страницы.

Об использовании 16 функций Google Таблиц для целей SEO читайте в нашей статье. Здесь все очень подробно расписано, с примерами по каждой функции.

Виды парсеров по сферам применения

Для организаторов СП (совместных покупок)

Есть специализированные парсеры для организаторов совместных покупок (СП). Их устанавливают на свои сайты производители товаров (например, одежды). И любой желающий может прямо на сайте воспользоваться парсером и выгрузить весь ассортимент.

Чем удобны эти парсеры:

- интуитивно понятный интерфейс;

- возможность выгружать отдельные товары, разделы или весь каталог;

- можно выгружать данные в удобном формате. Например, в Облачном парсере доступно большое количество форматов выгрузки, кроме стандартных XLSX и CSV: адаптированный прайс для Tiu.ru, выгрузка для Яндекс.Маркета и т. д.

Популярные парсеры для СП:

Парсеры цен конкурентов

Инструменты для интернет-магазинов, которые хотят регулярно отслеживать цены конкурентов на аналогичные товары. С помощью таких парсеров вы можете указать ссылки на ресурсы конкурентов, сопоставлять их цены с вашими и корректировать при необходимости.

Вот три таких инструмента:

Парсеры для быстрого наполнения сайтов

Такие сервисы собирают названия товаров, описания, цены, изображения и другие данные с сайтов-доноров. Затем выгружают их в файл или сразу загружают на ваш сайт. Это существенно ускоряет работу по наполнению сайта и экономят массу времени, которое вы потратили бы на ручное наполнение.

В подобных парсерах можно автоматически добавлять свою наценку (например, если вы парсите данные с сайта поставщика с оптовыми ценами). Также можно настраивать автоматический сбор или обновление данных по расписания.

Примеры таких парсеров:

Парсеры для SEO-специалистов

Отдельная категория парсеров — узко- или многофункциональные программы, созданные специально под решение задач SEO-специалистов. Такие парсеры предназначены для упрощения комплексного анализа оптимизации сайта. С их помощью можно:

- анализировать содержимое robots.txt и sitemap.xml;

- проверять наличие title и description на страницах сайта, анализировать их длину, собирать заголовки всех уровней (h1-h6);

- проверять коды ответа страниц;

- собирать и визуализировать структуру сайта;

- проверять наличие описаний изображений (атрибут alt);

- анализировать внутреннюю перелинковку и внешние ссылки;

- находить неработающие ссылки;

- и многое другое.

Пройдемся по нескольким популярным парсерам и рассмотрим их основные возможности и функционал.

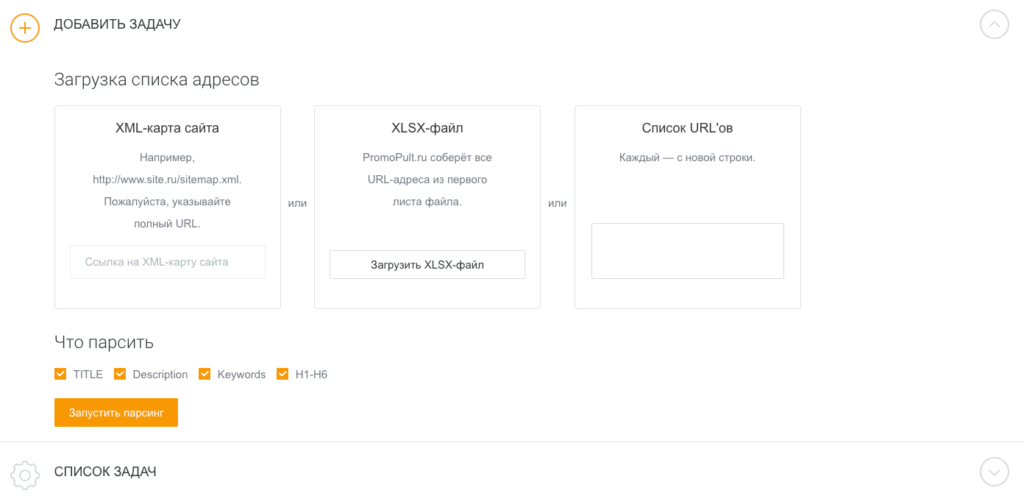

Парсер метатегов и заголовков PromoPult

Стоимость: первые 500 запросов — бесплатно. Стоимость последующих запросов зависит от количества: до 1000 — 0,04 руб./запрос; от 10000 — 0,01 руб.

Возможности

С помощью парсера метатегов и заголовков можно собирать заголовки h1-h6, а также содержимое тегов title, description и keywords со своего или чужих сайтов.

Инструмент пригодится при оптимизации своего сайта. С его помощью можно обнаружить:

- страницы с пустыми метатегами;

- неинформативные заголовки или заголовки с ошибками;

- дубли метатегов и т.д.

Также парсер полезен при анализе SEO конкурентов. Вы можете проанализировать, под какие ключевые слова конкуренты оптимизируют страницы своих сайтов, что прописывают в title и description, как формируют заголовки.

Сервис работает «в облаке». Для начала работы необходимо добавить список URL и указать, какие данные нужно спарсить. URL можно добавить вручную, загрузить XLSX-таблицу со списком адресов страниц, или вставить ссылку на карту сайта (sitemap.xml).

Работа с инструментом подробно описана в статье «Как в один клик собрать мета-теги и заголовки с любого сайта?».

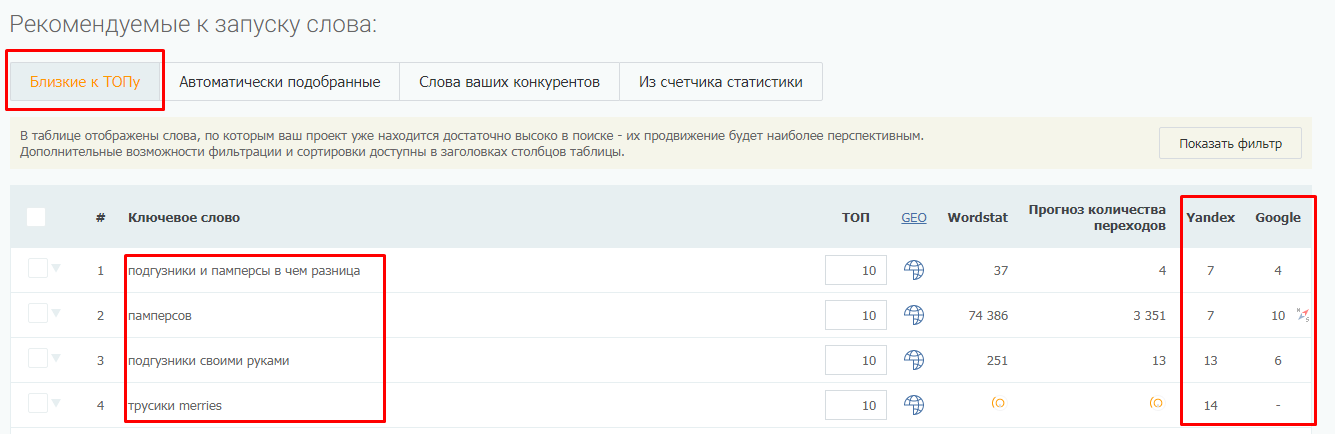

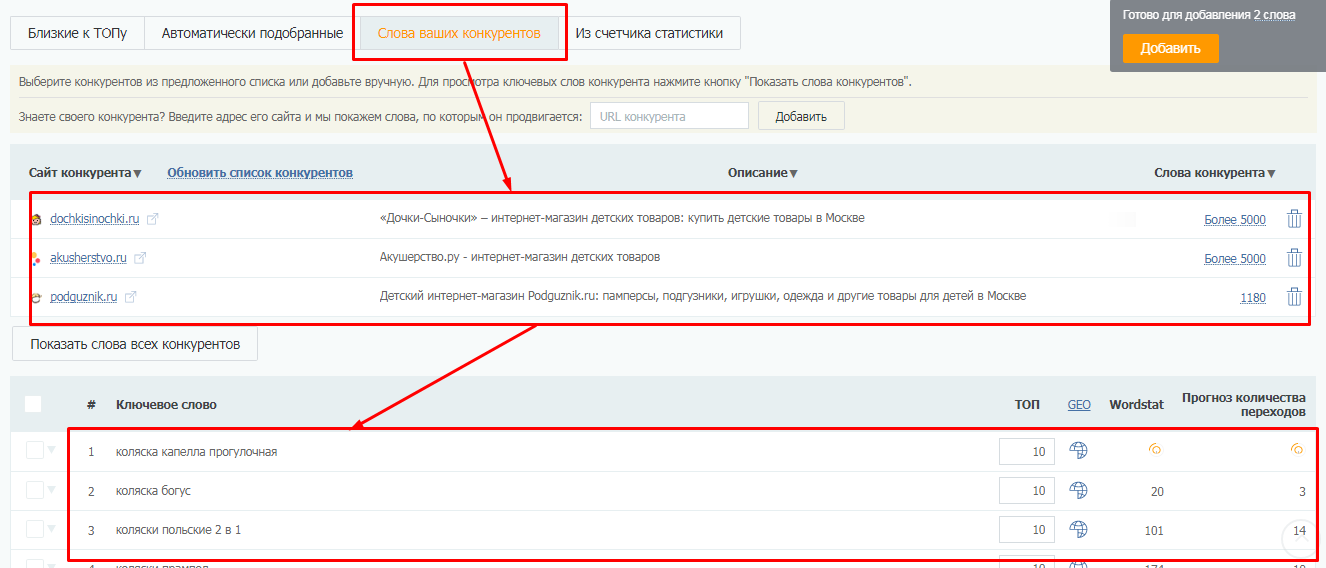

Парсер метатегов и заголовков — не единственный инструмент системы PromoPult для парсинга. В SEO-модуле системы можно бесплатно спарсить ключевые слова, по которым добавленный в систему сайт занимает ТОП-50 в Яндексе/Google.

Здесь же на вкладке “Слова ваших конкурентов” вы можете выгрузить ключевые слова конкурентов (до 10 URL за один раз).

Подробно о работе с парсингом ключей в SEO-модуле PromoPult читайте здесь.

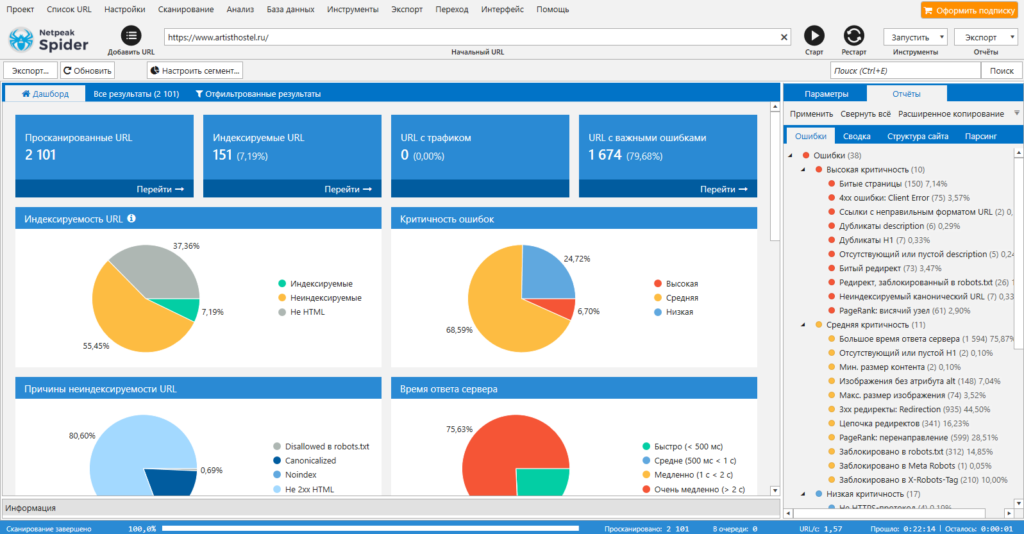

Netpeak Spider

Стоимость: от 19$ в месяц, есть 14-дневный пробный период.

Парсер для комплексного анализа сайтов. С Netpeak Spider можно:

- провести технический аудит сайта (обнаружить битые ссылки, проверить коды ответа страниц, найти дубли и т.д.). Парсер позволяет находить более 80 ключевых ошибок внутренней оптимизации;

- проанализировать основные SEO-параметры (файл robots.txt, проанализировать структуру сайта, проверить редиректы);

- парсить данные с сайтов с помощью регулярных выражений, XPath-запросов и других методов;

- также Netpeak Spider может импортировать данные из Google Аналитики, Яндекс.Метрики и Google Search Console.

Screaming Frog SEO Spider

Стоимость: лицензия на год — 149 фунтов, есть бесплатная версия.

Многофункциональный инструмент для SEO-специалистов, подходит для решения практически любых SEO-задач:

- поиск битых ссылок, ошибок и редиректов;

- анализ мета-тегов страниц;

- поиск дублей страниц;

- генерация файлов sitemap.xml;

- визуализация структуры сайта;

- и многое другое.

В бесплатной версии доступен ограниченный функционал, а также есть лимиты на количество URL для парсинга (можно парсить всего 500 url). В платной версии таких лимитов нет, а также доступно больше возможностей. Например, можно парсить содержимое любых элементов страниц (цены, описания и т.д.).

Подробно том, как пользоваться Screaming Frog, мы писали в статье «Парсинг любого сайта «для чайников»: ни строчки программного кода».

ComparseR

Стоимость: 2000 рублей за 1 лицензию. Есть демо-версия с ограничениями.

Еще один десктопный парсер. С его помощью можно:

- проанализировать технические ошибки на сайте (ошибки 404, дубли title, внутренние редиректы, закрытые от индексации страницы и т.д.);

- узнать, какие страницы видит поисковой робот при сканировании сайта;

- основная фишка ComparseR — парсинг выдачи Яндекса и Google, позволяет выяснить, какие страницы находятся в индексе, а какие в него не попали.

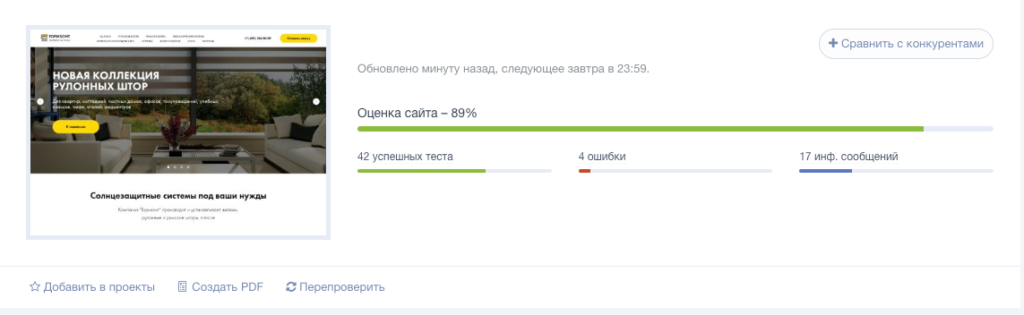

Анализ сайта от PR-CY

Стоимость: платный сервис, минимальный тариф — 990 рублей в месяц. Есть 7-дневная пробная версия с полным доступом к функционалу.

Онлайн-сервис для SEO-анализа сайтов. Сервис анализирует сайт по подробному списку параметров (70+ пунктов) и формирует отчет, в котором указаны:

- обнаруженные ошибки;

- варианты исправления ошибок;

- SEO-чеклист и советы по улучшению оптимизации сайта.

Анализ сайта от SE Ranking

Стоимость: платный облачный сервис. Доступно две модели оплаты: ежемесячная подписка или оплата за проверку.

Стоимость минимального тарифа — 7$ в месяц (при оплате годовой подписки).

Возможности:

- сканирование всех страниц сайта;

- анализ технических ошибок (настройки редиректов, корректность тегов canonical и hreflang, проверка дублей и т.д.);

- поиск страниц без мета-тегов title и description, определение страниц со слишком длинными тегами;

- проверка скорости загрузки страниц;

- анализ изображений (поиск неработающих картинок, проверка наличия заполненных атрибутов alt, поиск «тяжелых» изображений, которые замедляют загрузку страниц);

- анализ внутренних ссылок.

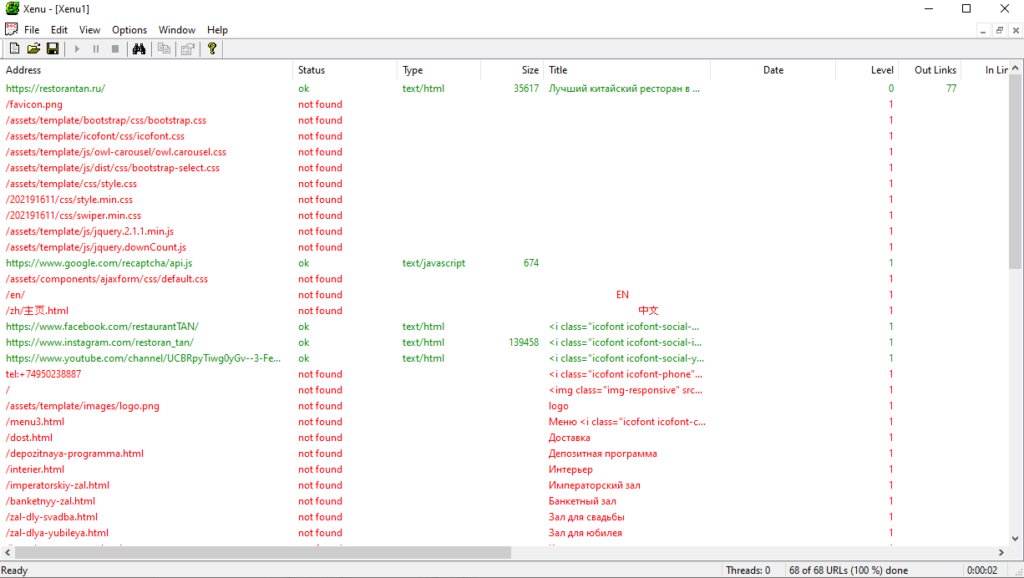

Xenu’s Link Sleuth

Стоимость: бесплатно.

Десктопный парсер для Windows. Используется для парсинга все url, которые есть на сайте:

- ссылки на внешние ресурсы;

- внутренние ссылки (перелинковка);

- ссылки на изображения, скрипты и другие внутренние ресурсы.

Часто применяется для поиска неработающих ссылок на сайте.

A-Parser

Стоимость: платная программа с пожизненной лицензией. Минимальный тарифный план — 119$, максимальный — 279$. Есть демо-версия.

Многофункциональный SEO-комбайн, объединяющий 70+ разных парсеров, заточенных под различные задачи:

- парсинг ключевых слов;

- парсинг данных с Яндекс и Google карт;

- мониторинг позиций сайтов в поисковых системах;

- парсинг контента (текст, изображения, видео) и т.д.

Кроме набора готовых инструментов, можно создать собственный парсер с помощью регулярных выражений, языка запросов XPath или Javascript. Есть доступ по API.

Чек-лист по выбору парсера

Краткий чек-лист, который поможет выбрать наиболее подходящий инструмент или сервис.

- Четко определите, для каких задач вам нужен парсер: анализ SEO конкурентов или мониторинг цен, сбор данных для наполнения каталога, съем позиций и т.д.

- Определите, какой объем данных и в каком виде нужно получать.

- Определите, как часто вам нужно собирать данные: единоразово или с определенной периодичностью (раз в день/неделю/месяц).

- Выберите несколько инструментов, которые подходят для решения ваших задач. Попробуйте демо-версии. Узнайте, предоставляется ли техническая поддержка (желательно даже протестировать ее — задать парочку вопросов и посмотреть, как быстро вы получите ответ и насколько он будет исчерпывающим).

- Выберите наиболее подходящий сервис по соотношению цена/качество.

Для крупных проектов, где требуется парсить большие объемы данных и производить сложную обработку, более выгодной может оказаться разработка собственного парсера под конкретные задачи.

Для большинства же проектов достаточно будет стандартных решений (возможно, вам может быть достаточно бесплатной версии любого из парсеров или пробного периода).

Сервисы для автоматического сбора семантического ядра

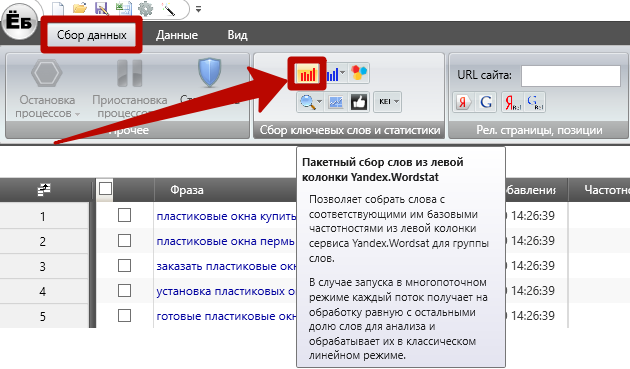

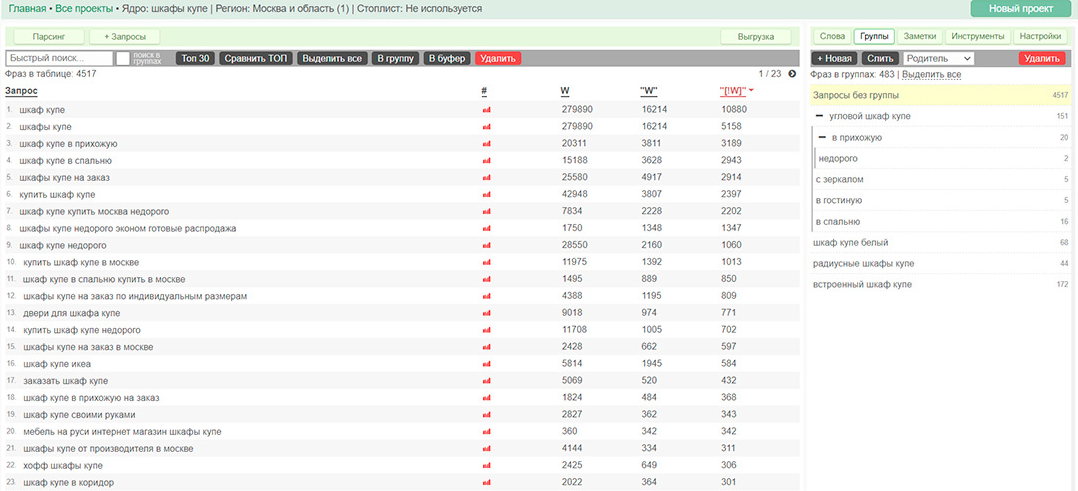

Key Collector

- Из самых разных популярных источников (среди них – рекламные сервисы Yandex Wordstat, Google Ads, Rambler Adstat) и поисковых подсказок систем;

- Вместе со статистикой из Liveinternet, Google Analytics, Яндекс.Метрики, Яндекс.Вебмастер, Serpstat и других сервисов;

- С учетом конкретного региона и сезонности;

- По нужной глубине поиска;

- С оценками стоимости продвижения, популярности, конкуренции, трафика и других параметров;

- Со значениями частотности;

- С возможностью последующей группировки (кластеризации);

- С возможностью составления минус-списков.

SEO 4.0: курс по продвижению сайтов в интернете. Приводи сотни тысяч клиентов в месяц из Яндекса и Google. Успей на раннее бронирование!Курс Яндекс.Директ: эффективная настройка методом гиперсегментации. Наш the best курсКурс по продающим сайтам. Без опыта в программировании, копирайтинге и дизайне.

Словоеб

- Левой и правой колонок Wordstat;

- Rambler.Adstat;

- Поисковых подсказок Яндекса и Google.

Повышение конверсии сайта турфирмы в 2,7 раза. Кейс YaglaКак снизить стоимость лида в 3 раза за 3 недели. Кейс компании по бухгалтерским услугам

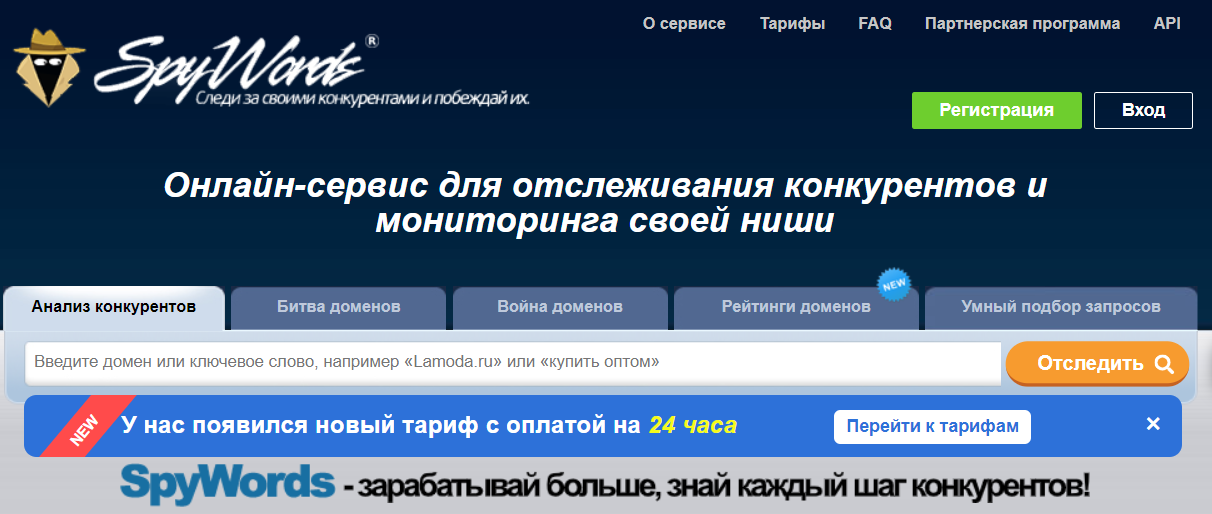

SpyWords

Keys.so

Rush Analytics

- Проверяет позиции в Яндекс и Google;

- Выполняет кластеризацию запросов;

- Собирает ключевые слова на основе поисковых подсказок;

- Собирает данные из Яндекс.Wordstat в облаке;

- Проверяет индексацию URL;

- Анализирует текст и другие зоны страниц.

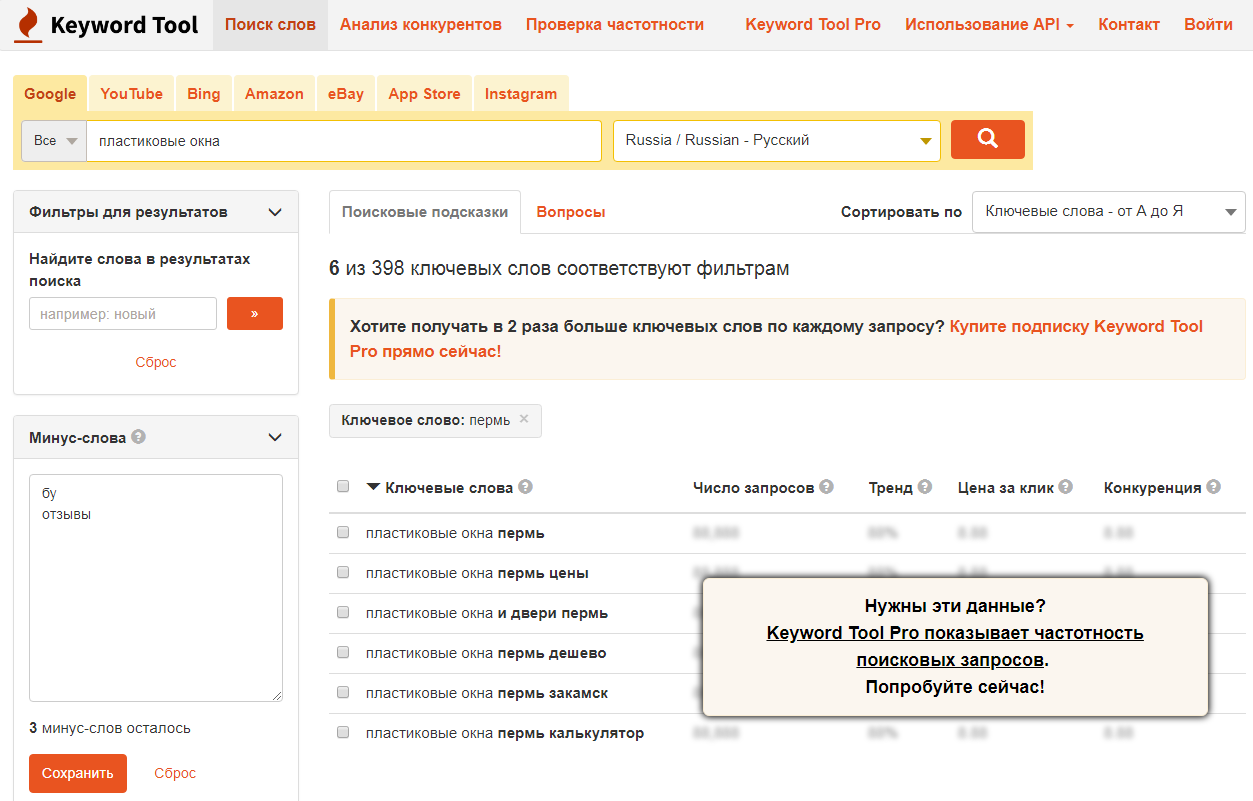

Keyword Tool

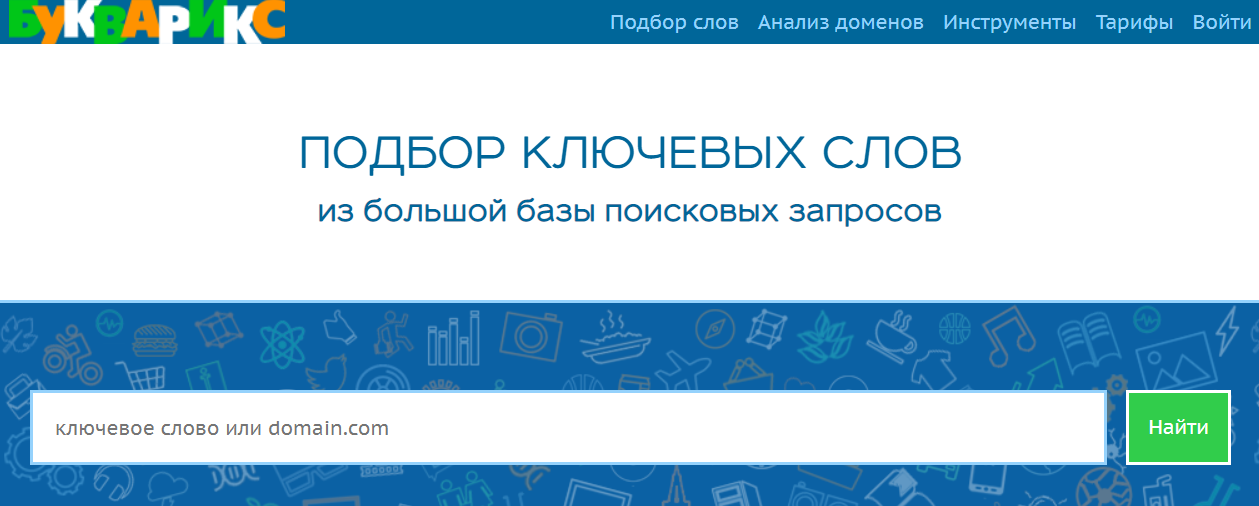

Букварикс

- Выяснить, какие слова подойдут для заданного вами сайта;

- Подсмотреть, какие ключи используют ваши конкуренты, но не используете вы.

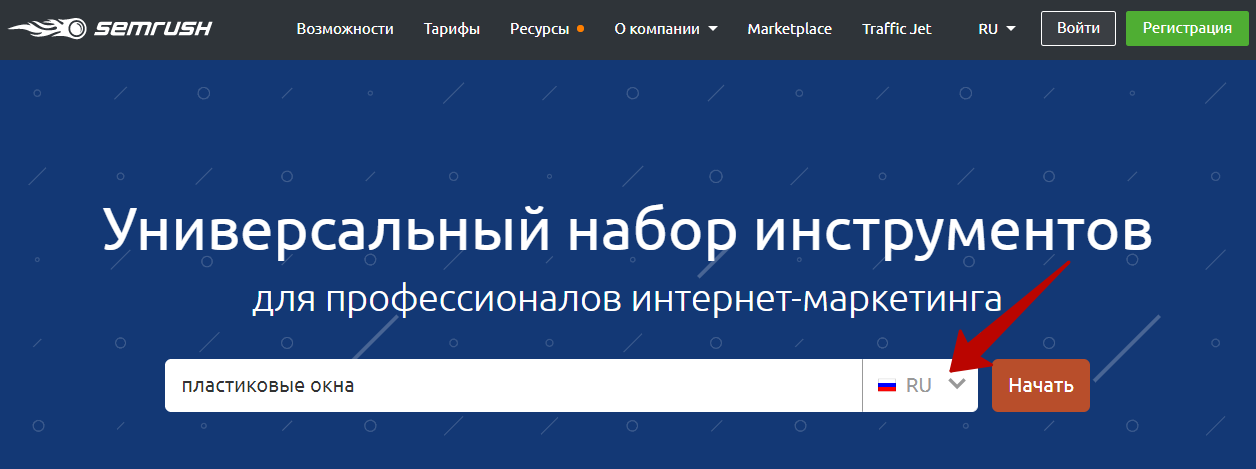

SemRush

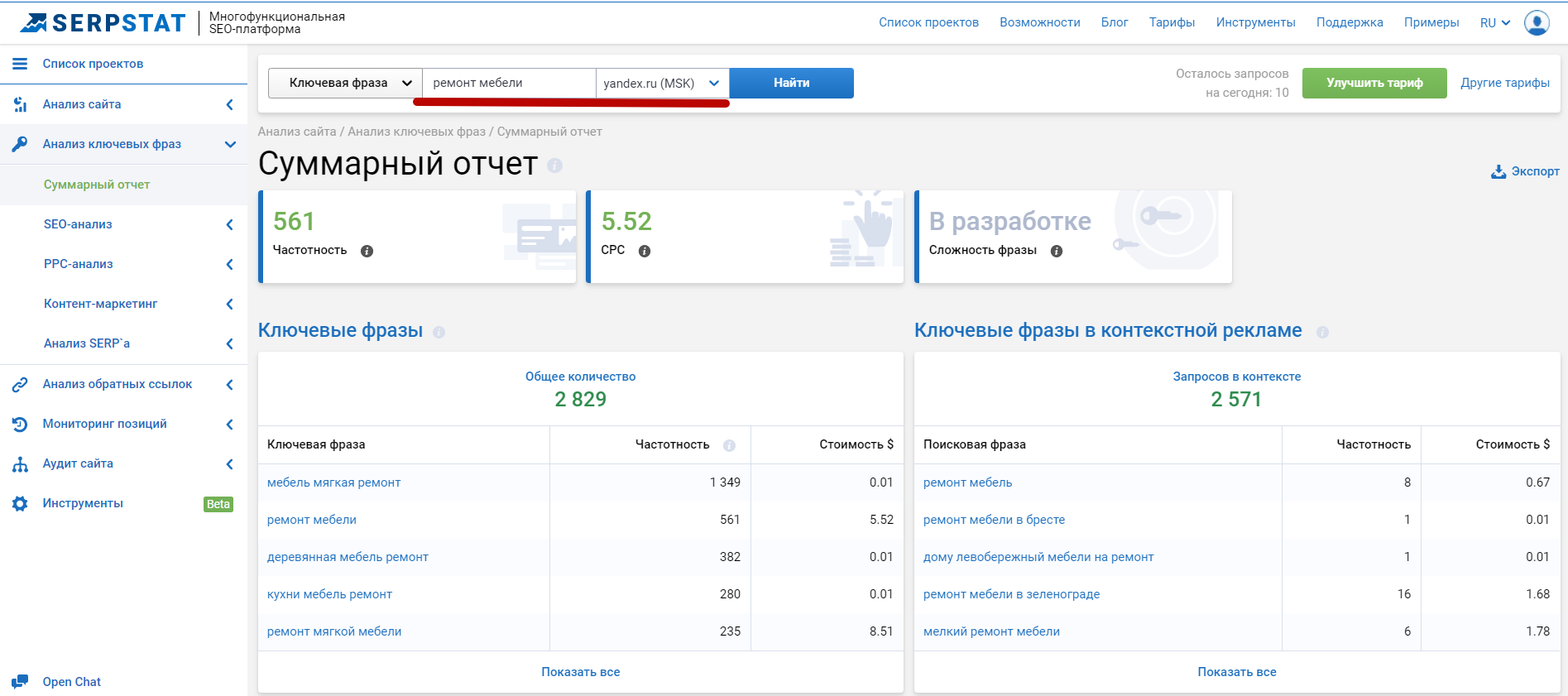

Serpstat

Word Keeper

Что не так с автоматическим сбором семантики

Парсеры Яндекс.Вордстат — 11 сервисов и расширений

Яндекс.Вордстат — бесплатный инструмент для сбора ключевых слов для рекламных кампаний и составления семантического ядра сайта. Парсеры позволяют ускорить и автоматизировать процесс сбора ключевиков. Они помогают отслеживать потребности ЦА, полезны при выборе маркетинговой стратегии, создании SEO-текстов и запуске рекламы. Парсеры — это один из инструментов работы SEO-специалистов.

В статье расскажем, какие парсеры подходят для сбора ключевых слов из Яндекс.Вордстат.

Читайте также: ТОП-10 курсов по SEO-продвижению

11 парсеров Яндекс.Вордстат: онлайн-сервисы, программы и бесплатные расширения

Рассказываем кратко о возможностях каждого сервиса. Основная функция большинства парсеров — поиск частотности по заранее заданному списку запросов. С разбивкой по регионам. Если кроме частотности нужен поиск запросов, связанных с исходным словом или похожие запросы, нужно уточнять, есть ли такая функция в сервисе.

P.S. Парсер может быть в виде самостоятельного сервиса, одной из функций другого сервиса или в виде расширения для браузеров. Чаще всего такие парсеры входят в функционал сервисов по комплексному продвижению в Интернете.

Это интересно: Виды поисковых запросов: полная классификация с примерами

1. Парсинг поисковых подсказок от Пиксель Тулс

Парсер в составе сервиса Пиксель Тулс. Сам сервис включает в себя несколько инструментов для SEO-продвижения. Парсер позволяет найти схожие ключевики на основе подсказок Яндекса.

Возможности:

- автоматический поиск подсказок (ключевых слов и фраз) — на основе перестановки слов, изменения начала/конца запроса, автосгенерированные;

- экспорт подсказок в виде отчета в CSV-файл;

- можно настроить регион;

- можно настроить глубину парсинга — искать по исходному запросу или к уже полученным подсказкам;

- настройка стоп-слов;

Цена: инструмент доступен только в составе сервиса Пиксель Тулс, отдельно оплатить нельзя. Тарифы сервиса — от 950 до 12 990 рублей в месяц.

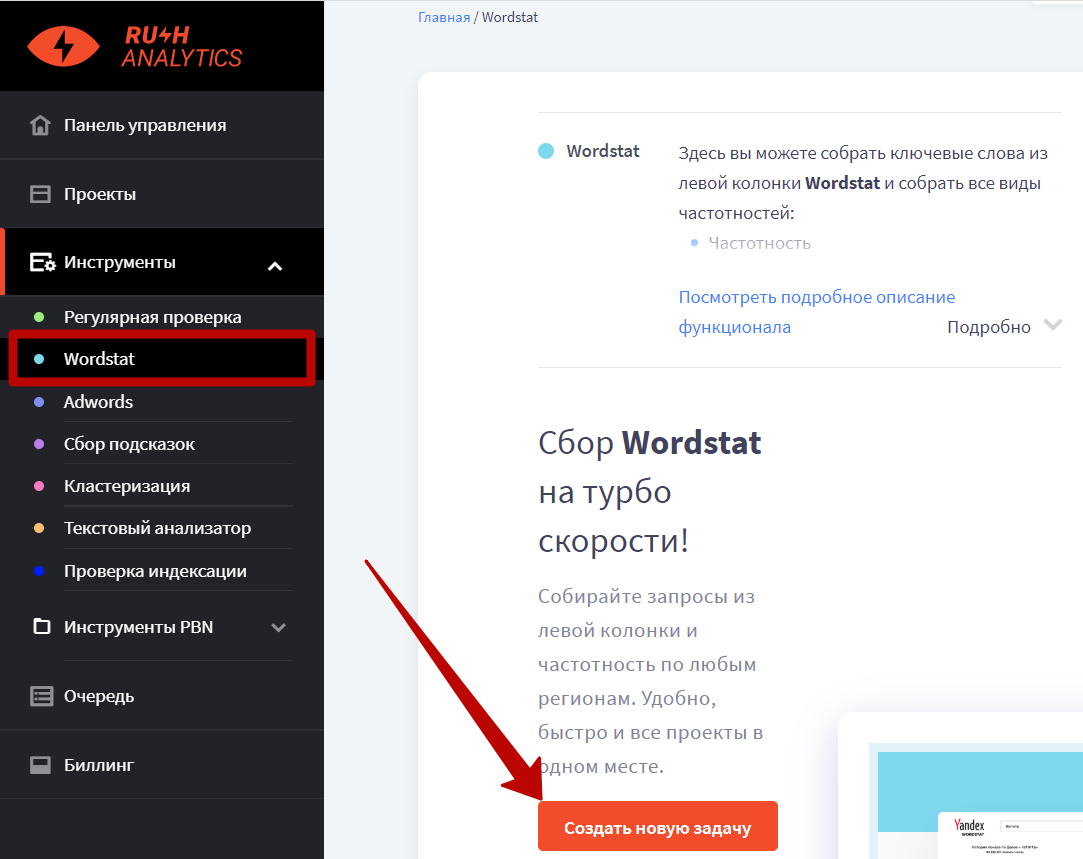

2. Парсер от Rush Analytics

Это тоже инструмент в составе сервиса для комплексного SEO-продвижения.

Возможности:

- подбор ключевых слов и частотности (все виды);

- фильтрация гео-запросов;

- фильтрация по стоп-словам;

- кластеризация;

- сбор поисковых подсказок;

- точная проверка позиций в Яндекс (и Google);

Дополнительные фишки: высокая скорость парсинга (100 запросов в секунду), не нужно использовать прокси и вводить капчи. Есть инструмент проверки индексации.

Цена: чтобы пользоваться инструментом, нужно оплатить весь сервис (от 999 рублей в месяц при оплате за месяц). При этом оплата за запрос — 0,03 рубля за страницу Вордстат или 1 рубль за 40 страниц.

3. Парсер Wordstat от Click.ru

Парсер встроен в Click.ru — сервис для комплексной настройки и ведения рекламных кампаний.

Возможности:

- проверка частотности по заданному списку фраз из XLS-файла или при ручной загрузке списка;

- кластеризация запросов;

- выбор региона для парсинга;

- сбор поисковых подсказок;

- сбор фраз ассоциаций;

- парсер мета-тегов и заголовков

- составление заголовков и текстов для рекламных объявлений на основе найденных ключевиков;

- формирование отчетов в формате XLSX, которые хранятся в облаке;

- операторы соответствия ключевиков для более точной статистики (широкое соответствие, фиксация количества и порядка слов);

- встроенная защита от повторного парсинга по тем же запросам.

Дополнительные фишки: не нужно использовать прокси-серверы и вводить капчу.

Цена: доступно 50 запросов для теста, далее цены зависят от задачи и количества запросов. В среднем — от 0.02 до 0.12 рублей за запрос.

4. Key Collector

Key Collector — профессиональный инструмент для сбора семантического ядра. Это отдельная программа, которая устанавливается на ПК. Собирает ключевики из нескольких источников (более 30), а не только по Яндекс.Вордстат.

Возможности:

- несколько фильтров для отбора лучших запросов;

- есть дерево групп и редактор структуры — позволяет работать в одном файле, а не создавать несколько файлов под каждую группу;

- автоматическая и ручная кластеризация;

- поиск неявных дублей;

- фильтрация по стоп-словам;

- более 50 параметров статистики;

Дополнительная фишка: регулярные бесплатные обновления, коммьюнити пользователей.

Цена: бессрочная лицензия — 2 200 рублей без абонентской платы.

5. OverLead

Онлайн сервис для сбора ключевых слов с Яндекс.Вордстат.

Возможности:

- парсинг основных запросов;

- парсинг похожих запросов, синонимов и ассоциаций;

- сезонный парсинг;

- настройка региона сбора;

- можно установить глубину парсинга;

- есть настройка минус-слов и фильтры частотности;

Дополнительная фишка: + 100 рублей на баланс после регистрации, можно протестировать сервис. Не нужны прокси и капчи.

Цена: от 1 рубля за 60 ключей или 40 страниц. За 100 рублей можно собрать 7 500 ключей или 5 000 страниц.

6. MOAB.Tools Семантика

Онлайн-сервис для сбора семантики. Простой в использовании, без прокси, без капч. За 32 минуты можно собрать 2 млн фраз.

Возможности:

- сбор фраз с Yandex Wordstat, Яндекс.Подсказок и проверка частотности Yandex Wordstat;

- 71 вариант перебора запросов для поиска ультра-НЧ;

- выбор регионов;

- настройка глубины поиска;

- готовый файл с отчетом для скачивания;

Дополнительные фишки: 5 000 фраз в подарок. Интеграция с Key Collector. Бонусы при покупке сервиса.

Цена: в тарифе Mini можно получить до 50 000 фраз за 1 299 рублей.

7. Мутаген

Мутаген — это сервис для оптимизаторов, вебмастеров и копирайтеров. Один из инструментов — парсер Яндекс.Вордстат и Директ.

Возможности:

- парсинг ключей со всех страниц Вордстат (или только первой);

- определение частотности;

- доступна история проверок;

Цена: 2 копейки за запрос.

8. Букварикс

Программа для подбора слов по списку исходников или одному исходному слову.

Возможности:

- возможность выбора частотностей по двум типам запросов к Яндексу;

- модуль морфологии — позволяет получать ключевики с изменением падежа и числа;

- комбинатор слов;

- настройка минус-слов;

- поддержка более 80 регионов;

- экспорт в форматы .txt и .csv. с возможностью разбивки больших файлов на части.

Цена: ограниченная версия бесплатная, есть продвинутая за 695 рублей в месяц.

9. Парсеры — расширения для браузера

Расширения могут быть частью платного сервиса или самостоятельными. Во втором случае у них обычно ограниченный функционал, который подходит для небольших проверок.

Несколько полезных расширений:

Yandex Wordstat Assistant — ускоряет сбор фраз и определение частотности. Есть автоматическая проверка на дубли. Также есть несколько режимов сортировки: по порядку добавления, по алфавиту, по частотности.

WordStater для Wordstat — расширение от сервиса UTA-manager. Позволяет собрать семантику по конкретной ключевой фразе или списки минус-слов из Вордстата. Дополнительно можно спрогнозировать стоимость клика и количество посетителей Яндекс.Директ по собранным запросам.

Yandex Wordstat Helper — по принципу работы похоже на расширение Yandex Wordstat Assistant. Это виджет, который отображается на страницах Вордстата. Возможности: сбор ключевиков, проверка на дубли, автоматическая сортировка по алфавиту, копирование в один клик.

Заключение

Между парсерами Яндекс.Вордстат не так много отличий. Например, поиск частотности по слову или списку — стандартная функция парсера. У одних чуть больше функций, у других чуть меньше. А также отличаются лимиты и цена.

Для комплексного SEO-продвижения лучше брать парсер в составе сервисов, в которых есть сразу несколько инструментов. Например, Click.ru, Пиксель Тулс, Rush Analytics. Если нужны только ключевики, с этой задачей справится Key Collector, Мутаген, Букварикс. Для простых задач и небольших объемов можно обойтись расширениями.

Полезные статьи:

Боты против людей Статья

Автоматизация продаж в B2B от сервиса Snov.io: особенности, функционал и преимущества проекта Статья

5 ситуаций, которые можно обратить в свою пользу и увеличить конверсию — разбор от Calltouch Статья

Трафик для остеопатов, кинезиологов и мануальных терапевтов Статья

Особенности работы таргетолога в нише инфобизнеса Статья

Как создавать сайты с высокой конверсией на мобильных устройствах Статья

«Слушаю клиентов до потери пульса»: история специалиста по гиперсегментации

Как снизить в 3,5 раза стоимость заявки в несезон. Кейс театральной студии для детей

Как снизить стоимость целевого действия в 2 раза, когда ничего не помогает. Кейс сервиса DeliDela

Как получить конверсию сайта 30% на суперконкурентном рынке. Кейс по ремонту телефонов

Кейс онлайн-школа сценаристики и режиссуры Статья

Нейросети для создания видео: от подготовки сценария до постпродакшена Статья

Какие бывают трудности в коммуникации с заказчиками? Как их решать? Статья

Примеры роста конверсий, заказов и прибыли

«Слушаю клиентов до потери пульса»: история специалиста по гиперсегментации

Как снизить в 3,5 раза стоимость заявки в несезон. Кейс театральной студии для детей

Как снизить стоимость целевого действия в 2 раза, когда ничего не помогает. Кейс сервиса DeliDela

Как получить конверсию сайта 30% на суперконкурентном рынке. Кейс по ремонту телефонов